Le développement de certaines technologies telles que la robotique, l’intelligence artificielle et la 5G permettent aujourd’hui de garantir l’autonomie complète de tout type de véhicule (voitures, bateaux, aéronefs, etc.). L’être humain-conducteur se voit peu à peu remplacé par une « machine » capable d’exécuter des actions spécifiques sur la base de conditions préétablies (par exemple, se parquer, freiner lorsqu’une personne traverse la rue, ou encore doubler un véhicule en respectant les distances de sécurité). L’utilisation de voitures autonomes permettrait de réduire les accidents dus aux erreurs humaines, qui représentent plus de 90% de l’ensemble des accidents de la circulation routière. De plus, l’automatisation rendrait la conduite plus « économique », éviterait les nuisances sonores et permettrait de satisfaire le besoin de mobilité grandissant de la population, notamment des personnes à mobilité réduite.

Cependant, un certain nombre d’accidents mortels impliquant des voitures autonomes viennent entacher cette « course » à l’automatisation. En 2018, une piétonne est tuée par un véhicule autonome Uber en Arizona alors qu’elle traversait la rue. Récemment, deux personnes sont décédées aux États-Unis au volant d’une voiture Tesla à la suite d’un accident vraisemblablement causé par le système de pilotage automatique du véhicule (automated driving system, ADS). Le patron de Tesla, Elon Musk, rejette toute responsabilité de l’entreprise et affirme que les données récupérées auprès du véhicule – la fameuse « boîte noire » – démontrent que l’ADS n’était pas activé au moment de l’accident (Tweet d’@elonmusk, 19 avril 2021). Toutefois, selon les premières investigations, aucun individu ne semblait se trouver sur le siège conducteur au moment de l’accident.

Ces cas d’accident posent évidemment la question de la responsabilité des acteurs impliqués, soit principalement du détenteur, du conducteur et du constructeur automobile.

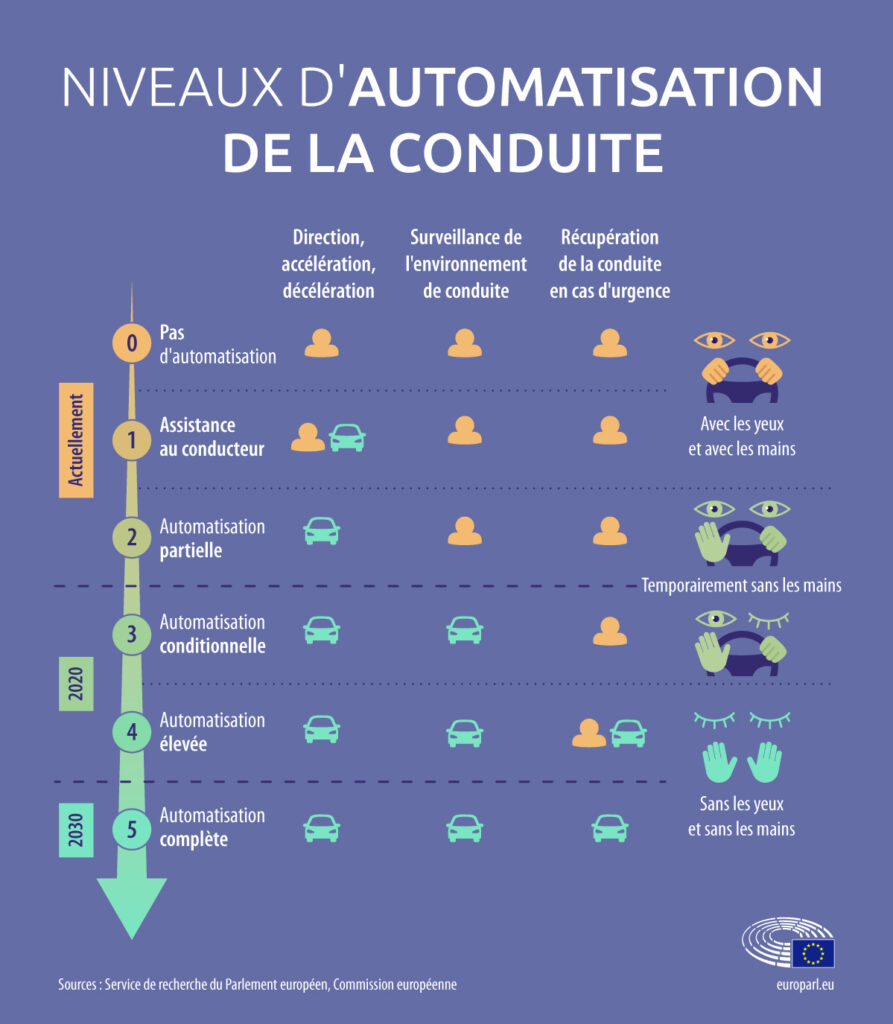

Généralement, l’autonomie d’un véhicule se décline en six niveaux allant de zéro (absence totale d’automatisation) à cinq (voiture complètement autonome), dont trois niveaux nous intéressent particulièrement dans le cadre de ce blog (OFROU, Niveaux d’automatisation) :

- Le niveau 3 vise l’automatisation conditionnelle : le système assure le guidage du véhicule pendant un certain temps et dans des conditions spécifiques, mais la personne doit être à même de reprendre le volant à tout moment (voir l’exemple de Honda).

- Le niveau 4 vise l’automatisation élevée : le système maîtrise toutes les situations dans des conditions d’utilisation définies, mais la personne doit reprendre le volant lorsque ces conditions changent (voir l’exemple de Mercedes-Benz : seule la fonction « parking » est de niveau 4).

- Le niveau 5 vise l’automatisation complète : le véhicule ne nécessite plus de conducteur, du départ à l’arrivée. Ces véhicules devraient être introduits sur le marché européen d’ici 2030.

Les niveaux d’automatisation 3, 4 et 5 impliquent de facto un transfert de responsabilité du conducteur à la « machine ». En cas d’accident causé par le logiciel, des questions juridiques et éthiques importantes se posent en matière de responsabilité. Qui est responsable et sur quelle base juridique ? Est-ce le détenteur, le conducteur, le constructeur automobile, l’importateur (vendeur), voire le ou les concepteurs du logiciel ?

À ce jour, tout véhicule en mouvement doit avoir un conducteur (un être humain) qui doit rester maître de son véhicule en toutes circonstances (art. 8 par. 1 et 5 et art. 13 par. 1 de la Convention de Vienne sur la circulation routière de 1968). Les systèmes d’assistance à la conduite doivent pouvoir être neutralisés ou désactivés par le conducteur à tout moment (art. 8 par. 5bis, 2e par. de la Convention). En d’autres termes, la présence et le contrôle du conducteur dans et respectivement sur le véhicule restent obligatoires, ce qui exclut les voitures complètement autonomes (niveau 5) du champ d’application de la Convention.

À l’échelle nationale, certains États ont légiféré et/ou mené des expériences en matière de véhicules autonomes. Le législateur allemand a par exemple introduit en 2017 les § 1a et 1b dans son Straßenverkehrsgesetz (StVG). Selon le § 1b, les systèmes de conduite hautement ou entièrement automatisés sont autorisés. Le conducteur doit toutefois être en mesure de reprendre le contrôle du véhicule lorsque le système le lui indique ou si, selon les circonstances, le conducteur reconnaît (ou devrait reconnaître) que les conditions d’utilisation du système autonome ne sont plus remplies. Le détenteur du véhicule reste entièrement responsable en cas d’accident (§ 7 ss StVG).

En Suisse, le détenteur du véhicule reste de lege lata responsable pour les dommages causés lors d’un accident (art. 58 al. 1 de la loi fédérale sur la circulation routière, LCR). Le logiciel intégré à la voiture représente également un « produit » au sens de la loi fédérale sur la responsabilité du fait des produits (art. 3 LRFP). En cas d’accident, l’assurance responsabilité civile du détenteur du véhicule pourrait en théorie agir contre le constructeur automobile (ou le concepteur du logiciel) dans le cadre d’une action récursoire sur la base de la LRFP (sur les autres fondements possibles de l’action récursoire, voir Brulhart/Gaulis, p. 25 à 29). Dans la même optique, le constructeur automobile Tesla exclut contractuellement sa responsabilité en cas d’accident, en soulignant que « l’autopilote et les systèmes de conduite complètement autonomes doivent être utilisés par un conducteur attentif, qui a ses mains sur le volant et est prêt à reprendre le contrôle du véhicule à tout moment (…). Les fonctions actuelles ne rendent pas le véhicule autonome. » (https://www.tesla.com/fr_FR/support/autopilot-and-full-self-driving-capability).

Il résulte de la responsabilité imposée au détenteur (et au conducteur) une certaine dichotomie entre la mise à disposition de systèmes de conduite autonome par les constructeurs, d’une part, et l’obligation faite aux conducteurs de garder le contrôle sur le véhicule en tout temps, d’autre part. Des recherches – et des vidéos amateures – démontrent que les utilisateurs de voitures autonomes sont susceptibles d’être distraits, voire de s’endormir au volant. Cela traduit un tragique excès de confiance des conducteurs envers la technologie, qui n’est à ce jour pas assez « mature ». En outre, il faudrait en moyenne dix secondes à une personne pour réagir à un événement soudain et imprévisible, ce qui, lorsque le véhicule roule à moyenne ou grande vitesse, représente un danger considérable. Les accidents impliquant des véhicules autonomes démontrent que les logiciels ne sont pas capables d’analyser toute situation accidentogène et que l’attention humaine reste indispensable. Certaines personnes et certains objets sont en effet confondus ou ne sont tout simplement pas détectés.

Pour toutes ces raisons, l’on peut se poser la question de l’opportunité (et de la nécessité) d’un glissement de la responsabilité du détenteur du véhicule vers le constructeur automobile ou le concepteur du logiciel. En effet, c’est à ces entités que revient la tâche – certes ardue mais essentielle – de mettre au point un système qui respecte les standards de sécurité minimaux en matière de circulation routière. Il paraît en effet injuste de faire porter aux utilisateurs de nouvelles technologies le poids de la responsabilité en cas d’accident.

Ce glissement de la responsabilité peut intervenir de plusieurs façons. Le législateur pourrait soit étendre la notion de détenteur pour y inclure celle de constructeur, soit créer une responsabilité propre à charge de ce dernier, lorsqu’il est établi que l’accident a eu lieu en mode autonome. Finalement, l’on pourrait également imaginer attribuer aux « robots » une personnalité juridique, ces derniers pouvant ainsi être tenus pour responsables des dommages qu’ils ont causés. Cette solution, qui avait été évoquée par le Parlement européen dans une Résolution publiée en février 2017 sur l’élaboration de règles de droit civil sur la robotique, obligerait le constructeur à s’assurer pour les éventuels dommages causés par les robots qu’il a créés (Document A8-0005/2017, consid. 59 let. f).

En Suisse, plusieurs expérimentations isolées impliquant des véhicules autonomes ont été autorisées sur la voie publique par le Conseil fédéral, sur la base de l’art. 106 al. 5 LCR (OFROU, Résultats des expérimentations faites avec des véhicules automatisés). Lorsque les véhicules complètement autonomes seront mis en circulation, le législateur suisse devra se demander s’il est opportun d’adapter le droit de la responsabilité civile. Des standards sécuritaires devront impérativement être établis, de préférence à l’échelle régionale ou internationale dans la mesure où un véhicule autonome immatriculé dans un État, et ainsi autorisé dans celui-ci, peut aisément traverser les frontières étatiques et circuler dans un État où les systèmes autonomes sont interdits. Ces standards devront trouver le juste équilibre entre la sécurité des utilisateurs et le progrès technologique, qui ne doit pas être freiné par des impératifs sécuritaires trop stricts.

Pour aller plus loin :

- Parlement européen, Véhicules autonomes dans l’UE : de la science-fiction à la réalité.

- Neal E. Boudette, ‘It Happened So Fast’: Inside a Fatal Tesla Autopilot Accident, New York Times, 2019.

- Vincent Brulhart/Dimitri Gaulis, La responsabilité liée à l’utilisation de véhicules autonomes, in : Christine Chappuis/Bénédict Winiger (édit.), Responsabilité civile et nouvelles technologies – Journée de la responsabilité civile 2018, Genève, 2019, p. 11-43.

- Sam Levin, Uber crash shows ‘catastrophic failure’ of self-driving technology, experts say, The Guardian, 2018.

- Jérôme Perrin, Peut-on élaborer une politique éthique du véhicule autonome?, Revue Défense Nationale 2018, p. 193-211.

Suggested citation: Ferreira Leonel, Les voitures autonomes : vers un “glissement” en droit de la responsabilité civile ?, Blog of the LexTech Institute, 26 October 2021

Author(s) of this blog post

Assistant-doctorant en droit international privé et droit des successions à l'Université de Neuchâtel, intéressé par les enjeux juridiques liés à numérisation (blockchain, intelligence artificielle, résolution des litiges en ligne, digitalisation de la justice étatique).